复旦大学计算机科学技术学院自然语言处理团队郑骁庆和黄萱菁老师等在脉冲神经网络方面的研究工作被机器学习顶级国际会议ICLR 2023(The International Conference on Learning Representations)录用,论文题为《Spiking Convolutional Neural Networks for Text Classification》,该项工作较早验证了脉冲神经网络在语言处理任务上的可行性,并且发现脉冲神经网络天然具备较高的对抗鲁棒性。

基于深度学习的方法在图像、声音、语言等领域取得了令人瞩目的突破,但构建和使用深度学习模型(一般需要使用GPU计算设备)也带来了巨大的能源消耗。以训练GPT-3为例(ChatGPT的基础模型),大约需要190,000kWh的能量,而人类大脑进行感知、识别、认知、推理和控制等多种复杂活动只需要20W的能量,人工神经网络和生物神经网格在能耗方面的差异十分巨大。与生物神经元相似,脉冲神经网络(Spiking neural networks, SNNs)也采用离散脉冲来传递和处理信息,它即是目前最接近生物脑工作机制的网络,又是有望以节能和经济的方式实现深度学习模型的途径之一。

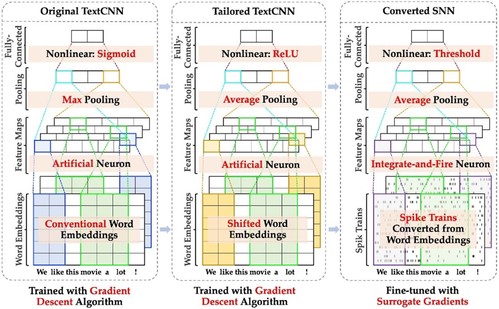

图1:“转换 + 精调”训练脉冲神经网络进行文本分类的两步法

目前少量研究已经表明脉冲神经网络在图像分类任务上的有效性,然而由于文本的离散表示和长度可变等特性使得脉冲神经网络一直较难处理自然语言方面的任务。针对上述问题,复旦大学计算机科学技术学院自然语言处理团队提出了“转换 + 精调”的两步训练方法,成功将脉冲神经网络应用于文本分类任务,其性能可媲美相同结构的深度神经网络,被国际同行评价道:目前鲜见能够表明脉冲神经网络在语言任务上有效性的工作,这篇论文取得了突破(“There are few works that demonstrate the efficacy of SNNs in language tasks. This paper makes a breakthrough.”)。这次被ICLR接收的论文主要贡献如下:

(1) 提出一种将预训练词或字向量以频率编码方式转换成脉冲的方法,从而能够利用大规模预训练所获得的丰富语义信息;

(2) 采用“转换 + 精调”两个步骤训练得到的脉冲神经网络在多个文本分类任务上达到或接近相同结构深度神经网络的性能,同时能耗最高可节省90%以上;

(3) 实验验证在对抗攻击下,脉冲神经网络的鲁棒性远高于传统的深度神经网络。

今后复旦大学计算机科学技术学院自然语言处理团队将持续探索脉冲神经网络用于构建大规模语言模型,以及在神经形态硬件上进行运行的可能性。论文作者还有吕昌泽和徐健涵两位研究生。